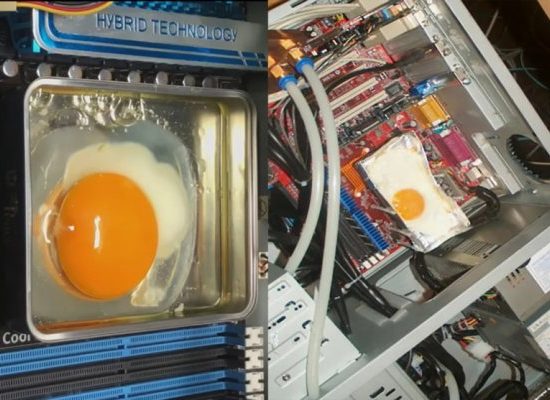

Навіть Pokémon не застрахований від суперечок щодо порівняльного аналізу ШІ.

Минулого тижня пост на X став вірусним, у якому стверджувалося, що остання модель Gemini від Google перевершила флагманську модель Anthropic Claude в оригінальній трилогії відеоігор Pokémon. Як повідомляється, Близнюки досягли Lavender Town у потоці розробника на Twitch; Наприкінці лютого Клод застряг на горі Мун .

Але в публікації не згадується, що Близнюки мали перевагу.

Як зазначили користувачі Reddit , розробник, який підтримує потік Gemini, створив спеціальну міні-карту, яка допомагає моделі ідентифікувати «плитки» в грі, як дерева, які можна розрізати. Це зменшує потребу Gemini аналізувати знімки екрана, перш ніж приймати рішення щодо ігрового процесу.

Зараз Pokémon є в кращому випадку напівсерйозним тестом штучного інтелекту — мало хто сперечатиметься, що це дуже інформативний тест можливостей моделі. Але це повчальний приклад того, як різні реалізації бенчмарку можуть впливати на результати.

Наприклад, Anthropic повідомила про два бали для своєї недавньої моделі Anthropic 3.7 Sonnet на тесті SWE-bench Verified, який призначений для оцінки можливостей кодування моделі. Claude 3.7 Sonnet досяг 62,3% точності на SWE-bench Verified, але 70,3% за допомогою «спеціального каркасу», розробленого Anthropic.

Нещодавно Meta налаштувала версію однієї зі своїх новіших моделей, Llama 4 Maverick, щоб добре працювати на певному тесті, LM Arena. Ванільна версія моделі має значно гірші результати за тією ж оцінкою.

З огляду на те, що тести штучного інтелекту, включно з покемонами, є недосконалими засобами , нестандартні та нестандартні впровадження загрожують ще більше замутити воду. Тобто навряд чи стане простіше порівнювати моделі після їх випуску.

No Comment! Be the first one.