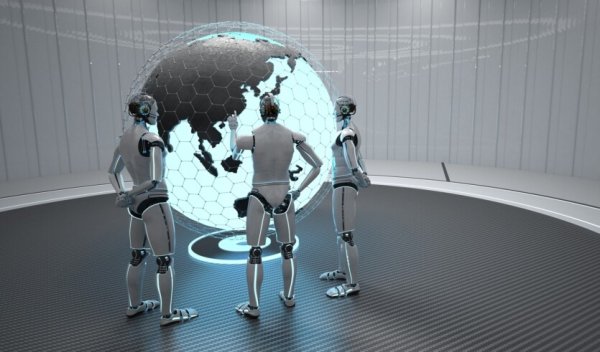

Канадские исследователи из Института Вейцмана и Intel Labs представили новый алгоритм, позволяющий различным моделям ИИ объединяться и работать вместе для повышения эффективности и уменьшения расходов.

Раздел Технологии выходит при поддержке

Каждая большая языковая модель (LLM) имеет свой уникальный электронный «язык». Однако до недавнего времени различные модели не могли напрямую взаимодействовать друг с другом. Ряд новых алгоритмов, предложенных канадскими исследователями, устраняет это ограничение, позволяя пользователям использовать общую вычислительную мощность нескольких моделей, ускоряя их работу в 1,5 раза.

Такие мощные LLM, как ChatGPT или Gemini, способны выполнять разнообразные сложные задачи. Однако сами по себе они остаются медленными и потребляют большое количество вычислительной мощности. В 2022 году технологические компании осознали, что модели ИИ могут быть более производительными и мощными, если будут работать совместно.

Таким образом был разработан метод, получивший название «спекулятивного декодирования». Этот метод предполагает, что небольшая и быстрая языковая модель с относительно ограниченным набором данных будет первой отвечать на запрос пользователя, более мощная и большая LLM будет анализировать и корректировать ответ при необходимости.

Такой подход позволил обеспечить 100% точность, в отличие от альтернативных методов ускорения, которые снижали качество исходных данных. Однако этот метод ограничивало то, что языковые модели должны были использовать один и тот же цифровой язык. Это не позволяло объединять модели разных компаний.

«Технологические гиганты перешли на спекулятивное декодирование, получая выгоду от более высокой производительности и экономя миллиарды долларов в год на стоимости вычислительной мощности, но только они имели доступ к небольшим, более быстрым моделям, говорящим на том же языке, что и более крупные модели. Стартапу, стремящемуся извлечь выгоду из спекулятивного декодирования, пришлось бы обучить собственную небольшую модель, которая соответствовала бы языку большой модели, а это требует большого опыта и дорогих вычислительных ресурсов», — объясняет руководитель исследования, аспирант исследовательской группы профессора Дэвида Харела на кафедре компьютерных наук и прикладной математики Университета Вейцмана, Надав Тимор.

Новые алгоритмы позволяют объединять любые небольшие модели ИИ с какими угодно большими. Исследователи разработали алгоритм, позволяющий LLM переводить исходные данные с внутреннего языка токенов в общий формат, понятный всем моделям. Другой алгоритм побуждает такие модели ИИ в совместной работе полагаться на токены, имеющие одинаковое значение для всех моделей.

Creators — агентство международного PR для технологических и B2B-компаний PR для компаний и их лидеров Организация интервью в медиа, подкастах, выступлений на конференциях Европа, Азия, Америка Узнать больше

«Сначала мы беспокоились, что слишком много информации будет «потеряно при переводе», и что разные модели не смогут эффективно взаимодействовать. Но мы ошибались. Наши алгоритмы ускоряют работу LLM до 2,8 раз, что приводит к значительной экономии вычислительной мощности», — отмечает Надав Тимор.

За последние несколько месяцев команда опубликовала свои алгоритмы на платформе искусственного интеллекта с открытым кодом Hugging Face Transformers, сделав их доступными для разработчиков по всему миру. С тех пор эти алгоритмы стали частью стандартных инструментов для эффективной реализации ИИ-процессов.

Результаты исследования опубликованы на сервере препринтов arXiv

Источник: TechXplore

Раздел Технологии выходит при поддержке

Favbet Tech – это IT-компания со 100% украинской ДНК, которая создает совершенные сервисы для iGaming и Betting с использованием передовых технологий и предоставляет доступ к ним. Favbet Tech разрабатывает инновационное программное обеспечение через сложную многокомпонентную платформу, способную выдерживать огромные нагрузки и создавать уникальный опыт для игроков.

No Comment! Be the first one.