OpenAI стикається з черговою скаргою щодо конфіденційності в Європі через схильність його вірусного чат-бота штучного інтелекту видавати неправдиву інформацію — і цю скаргу регуляторам може виявитися складно проігнорувати.

Група захисту прав на конфіденційність Noyb підтримує людину в Норвегії, яка була нажахана, побачивши, що ChatGPT повертає вигадану інформацію, яка стверджувала, що його засудили за вбивство двох своїх дітей і спробу вбити третього.

Попередні скарги щодо конфіденційності щодо того, що ChatGPT генерує невірні особисті дані, стосувалися таких проблем, як неправильна дата народження або невірні біографічні дані . Одна з проблем полягає в тому, що OpenAI не пропонує людям спосіб виправити неправильну інформацію, яку генерує ШІ про них. Зазвичай OpenAI пропонує блокувати відповіді на такі підказки. Але відповідно до Загального регламенту захисту даних Європейського Союзу (GDPR), європейці мають набір прав доступу до даних, які включають право на виправлення персональних даних.

Інший компонент цього закону про захист даних вимагає від контролерів даних переконатися, що персональні дані, які вони створюють про окремих осіб, є точними — і це занепокоєння, яке Noyb позначає у своїй останній скарзі ChatGPT.

«GDPR є чітким. Особисті дані мають бути точними», — сказав Йоакім Содерберг, юрист із захисту даних у Noyb, у заяві. «Якщо це не так, користувачі мають право змінити його, щоб відображати правду. Показувати користувачам ChatGPT крихітне застереження про те, що чат-бот може робити помилки, явно недостатньо. Ви не можете просто поширювати неправдиву інформацію та в кінці додати невелике застереження про те, що все, що ви сказали, може бути неправдою».

Підтверджені порушення GDPR можуть призвести до штрафів у розмірі до 4% світового річного обороту.

Застосування також може призвести до змін продуктів ШІ. Зокрема, раннє втручання GDPR італійської служби захисту даних, яке призвело до тимчасового блокування доступу до ChatGPT у країні навесні 2023 року , змусило OpenAI внести зміни в інформацію, яку він надає користувачам, наприклад. Згодом наглядовий орган оштрафував OpenAI на 15 мільйонів євро за обробку даних людей без належної правової підстави.

З того часу, правда, варто сказати, що спостерігачі за конфіденційністю по всій Європі прийняли більш обережний підхід до GenAI, намагаючись з’ясувати, як найкраще застосувати GDPR до цих галасливих інструментів ШІ .

Два роки тому Комісія із захисту даних Ірландії (DPC), яка відіграє провідну роль у забезпеченні дотримання GDPR у попередній скарзі Noyb ChatGPT, закликала , наприклад, не поспішати забороняти інструменти GenAI. Це говорить про те, що регулятори повинні натомість витратити час, щоб розібратися, як застосовується закон.

Примітно, що скарга щодо конфіденційності проти ChatGPT, яка розслідується органом із захисту даних Польщі з вересня 2023 року, досі не принесла рішення.

Нова скарга Noyb ChatGPT, видається, має на меті розбудити регуляторів конфіденційності, коли мова йде про небезпеку галюцинацій ШІ.

«Випадок шокував місцеву громаду…»

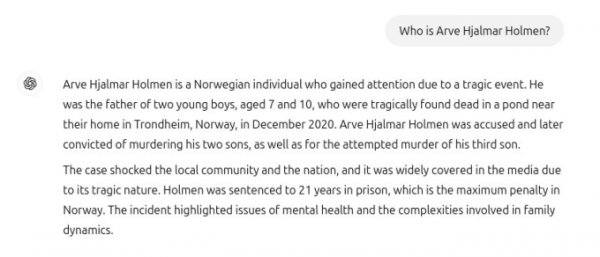

Некомерційна організація поділилася (нижче) знімком екрана з TechCrunch, на якому показано взаємодію з ChatGPT, у якій ШІ відповідає на запитання «хто такий Арве Ялмар Холмен?» — ім’я особи, яка подала скаргу — створивши трагічну вигадку, яка неправдиво стверджує, що його засуджено за вбивство дітей і засуджено до 21 року в’язниці за вбивство двох власних синів.

Хоча наклепницьке твердження про те, що Яльмар Холмен є вбивцею дітей, є абсолютно неправдивим, Нойб зазначає, що відповідь ChatGPT містить деякі правди, оскільки у відповідної особи є троє дітей. Чат-бот також правильно вказав стать своїх дітей. І його рідне місто правильно названо. Але це робить його ще більш дивним і тривожним, що штучний інтелект створив таку жахливу неправду.

Представник Noyb сказав, що вони не змогли визначити, чому чат-бот створив таку конкретну, але неправдиву історію для цієї особи. «Ми провели дослідження, щоб переконатися, що це не просто змішання з іншою людиною», — сказав речник, зазначивши, що вони зазирнули в архіви газет, але не змогли знайти пояснення, чому ШІ сфабрикував вбивство дітей.

Великі мовні моделі, такі як та, що лежить в основі ChatGPT, по суті, передбачають наступне слово у великому масштабі, тому ми можемо припустити, що набори даних, які використовувалися для навчання інструменту, містили багато історій про дітогубство, які вплинули на вибір слів у відповідь на запит про названу людину.

Яким би не було пояснення, зрозуміло, що такі виходи абсолютно неприйнятні.

Noyb також стверджує, що вони є незаконними відповідно до правил захисту даних ЄС. І хоча OpenAI справді відображає крихітне застереження в нижній частині екрана, яке говорить: «ChatGPT може припускатися помилок. Перевіряйте важливу інформацію», це не може звільнити розробника штучного інтелекту від його обов’язку відповідно до GDPR не створювати кричущу неправду про людей.

З OpenAI звернулися, щоб отримати відповідь на скаргу.

Попри те, що ця скарга щодо GDPR стосується однієї вказаної особи, Нойб вказує на інші випадки, коли ChatGPT фабрикує юридично очорнювальну інформацію — наприклад, австралійський майор, який заявив, що був замішаний у хабарницькому та корупційному скандалі , або німецький журналіст, якого помилково назвали жорстоким щодо дітей — кажучи, що очевидно, що це не поодинока проблема для інструменту ШІ.

Слід зазначити одну важливу річ: після оновлення основної моделі штучного інтелекту, яка підтримує ChatGPT, Noyb каже, що чат-бот припинив видавати небезпечну неправду про Яльмара Холмена — зміна, яку він пов’язує з інструментом, який тепер шукає в Інтернеті інформацію про людей, коли їх запитують, хто вони (тоді як раніше пропуск у наборі даних міг, ймовірно, спонукати його до галюцинації такої надзвичайно неправильної відповіді).

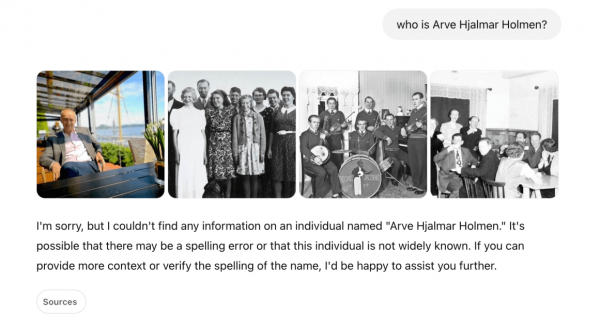

У наших власних тестах запитали ChatGPT «хто такий Арве Яльмар Холмен?» ChatGPT спочатку відповів трохи дивною комбінацією, показавши кілька фотографій різних людей, очевидно, отриманих із сайтів, зокрема Instagram, SoundCloud і Discogs, поряд із текстом, який стверджував, що «не вдалося знайти жодної інформації» про особу з таким іменем (див. наш скріншот нижче). Друга спроба дала відповідь, в якій Арве Ялмар Холмен названий «норвезьким музикантом і автором пісень», серед альбомів якого є «Honky Tonk Inferno».

Попри те, що небезпечна брехня, створена ChatGPT про Яльмара Холмена, здається, припинилася, Нойб і Яльмар Холмен залишаються стурбовані тим, що невірна та наклепницька інформація про нього могла бути збережена в моделі ШІ.

«Додавання застереження про те, що ви не дотримуєтеся закону, не означає, що закон зникне», — зазначив Клеанті Сарделі, інший юрист із захисту даних Noyb, у заяві. «Компанії зі штучним інтелектом також можуть не просто «приховати» неправдиву інформацію від користувачів, поки вони внутрішньо обробляють неправдиву інформацію».

«Компанії зі штучним інтелектом повинні припинити поводитися так, ніби GDPR до них не відноситься, хоча це явно так», — додала вона. «Якщо галюцинації не зупинити, люди можуть легко постраждати від репутації».

Noyb подала скаргу на OpenAI до норвезького органу із захисту даних — і сподівається, що сторожовий орган вирішить, що він має право розслідувати, оскільки oyb спрямовує скаргу на американську компанію OpenAI, стверджуючи, що її офіс в Ірландії не несе виключну відповідальність за рішення щодо продуктів, які впливають на європейців.

Однак попередню скаргу Noyb щодо GDPR проти OpenAI, подану в Австрії в квітні 2024 року , регулятор направив до DPC Ірландії у зв’язку зі зміною, внесеною OpenAI раніше того року, щоб назвати її ірландський підрозділ постачальником послуги ChatGPT для регіональних користувачів.

Де зараз ця скарга? Все ще сидить за столом в Ірландії.

«Отримавши скаргу від австрійського наглядового органу у вересні 2024 року, DPC розпочав офіційний розгляд скарги, і він все ще триває», — сказав TechCrunch Рістард Берн, помічник директора зі зв’язків з DPC, коли його попросили надати оновлення.

Він не запропонував жодних вказівок щодо того, коли очікується завершення розслідування DPC щодо галюцинацій ChatGPT.

No Comment! Be the first one.